【重制版】【人工智能】万字通俗讲解大语言模型内部运行原理 | LLM | 词向量 | Transformer | 注意力机制 | 前馈网络 | 反向传播 | 心智理论

32:48

【機器學習2021】Transformer (上)

55:34

一小時略懂 AI|GPT、Sora、Diffusion model、類器官智慧OI、圖靈測試、人工智慧史

31:52

许成钢谈经论政:DeepSeek是人工智能领域里的重大突破吗?

38:16

【生成式AI導論 2024】第10講:今日的語言模型是如何做文字接龍的 — 淺談Transformer (已經熟悉 Transformer 的同學可略過本講)

27:14

Transformers (how LLMs work) explained visually | DL5

26:10

Attention in transformers, step-by-step | DL6

28:18

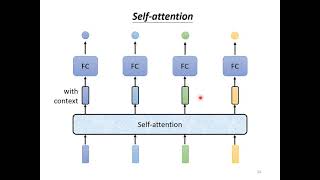

【機器學習2021】自注意力機制 (Self-attention) (上)

1:20:33