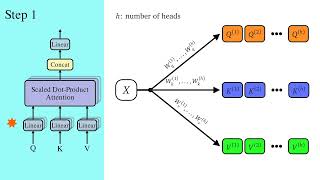

Explicando o Multi-head Attention no modelo Transformer | Deep Learning e NLP | Leonardo Ribeiro

17:53

Modelo Transformer | Mecanismo de atenção: Self-Attention | Deep Learning e NLP | Leonardo Ribeiro

18:52

Como o Transformer gera texto? | Processamento de Linguagem Natural | Leonardo F. R. Ribeiro

26:10

Attention in transformers, step-by-step | DL6

16:14

POR QUE se usa GPUs em Deep Learning? | Leonardo Ribeiro

3:21

Visão Computacional: O que é e 7 aplicações atuais

11:36

Como o Decoder do Transformer é treinado? | Leonardo F. R. Ribeiro

22:43

How might LLMs store facts | DL7

9:57