Transformer Interpretability 2: How can we explain the behaviour of neural models?

5:41

Transformer Interpretability 1: Why Interpretability is important in the Age of LLMs

6:44

3. How do Large Language Models work?

57:45

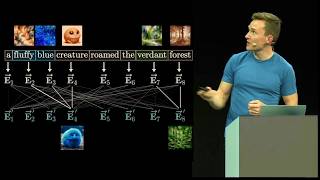

Visualizing transformers and attention | Talk for TNG Big Tech Day '24

22:59

Le paradoxe du dôme : une faille dans les lois de Newton

7:56

Transformer Interpretability 5: What is a circuit, and how does it explain LLM behavior?

29:54

Audition de Yann LeCun, Professeur à NYU et Scientifique en chef sur l'IA à Meta.

25:19

Prix Nobel de physique 2024 sur l'intelligence artificielle

30:52