Décomposer les transformateurs latents d'octets (BLT) - Les LLM sont devenus beaucoup plus intell...

57:45

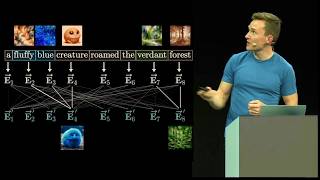

Visualizing transformers and attention | Talk for TNG Big Tech Day '24

22:10

Augmenter ChatGPT avec le RAG

44:53

Pré QSO des cheveux Gris animé par F5LTB Op Philippe : RX Lionel SWL 🎧F-80737🇫🇷 7️⃣3️⃣🤝29-12-2024

42:45

2024 in Post-Transformer Architectures: State Space Models, RWKV [Latent Space LIVE! @ NeurIPS 2024]

24:51

Il s'avère que l'attention n'était pas tout ce dont nous avions besoin - Comment les architecture...

31:34

Llama 3.3, pourquoi et comment mettre ce LLM en production + déploiement de modèles non censurés

22:59

Le paradoxe du dôme : une faille dans les lois de Newton

14:41