从编解码和词嵌入开始,一步一步理解Transformer,注意力机制(Attention)的本质是卷积神经网络(CNN)

26:58

从“卷积”、到“图像卷积操作”、再到“卷积神经网络”,“卷积”意义的3次改变

1:27:05

Transformer论文逐段精读

28:18

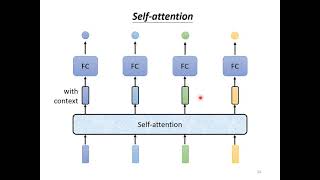

【機器學習2021】自注意力機制 (Self-attention) (上)

27:32

大模型解决不了英伟达的难题,AI新范式必将出现:专访安克创新CEO阳萌

18:10

人工智能是如何工作的?机器学习和神经网络又是什么?| 李永乐老师

30:36

【硬核科普】爆肝1万字!以十层理解带你深度解析光的本质!

27:14

Transformers (how LLMs work) explained visually | DL5

28:30